Tutte le attività che quotidianamente sono svolte sui dispositivi digitali producono dati, si tratta di una grandissima quantità di informazioni che possono essere raccolte, analizzate e quindi anche valorizzate dal punto di vista economico. Al giorno d’oggi i dati sono in continua crescita, se ne accumula ogni giorno un quantitativo enorme, miliardi e miliardi di dati.

La domanda che ci facciamo è: Come fanno le grandi aziende a gestire e controllare queste moli di dati cosi ampie?

Entrano in gioco i BigData…

BigData è un termine che descrive l’ampio volume di dati, sia strutturati che non strutturati, che inonda un’impresa quotidianamente. Ma non è la quantità di dati che è importante. È ciò che le organizzazioni fanno con i dati che contano. I dati possono essere analizzati per approfondimenti che portano a decisioni migliori e mosse strategiche.

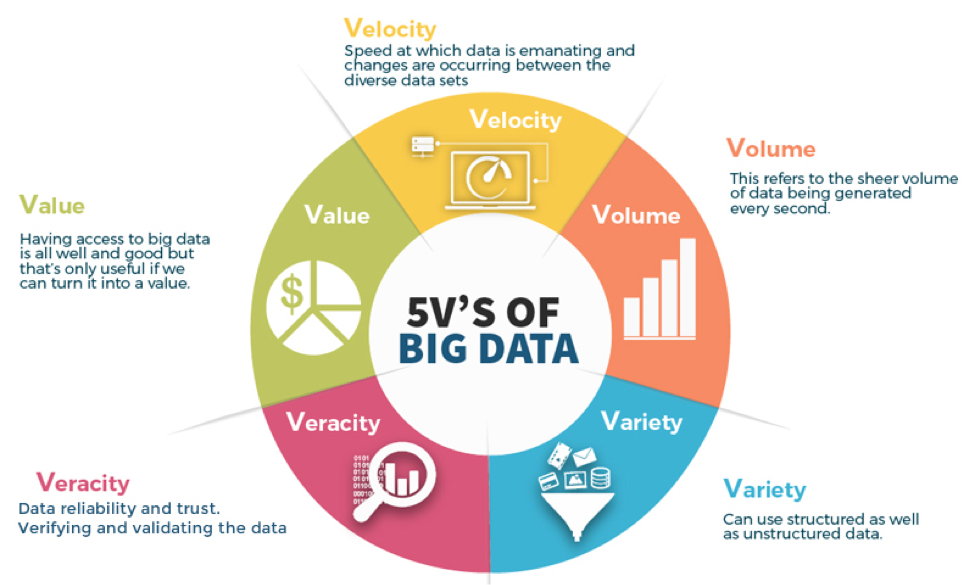

Volume, velocità, varietà, veridicità e valore sono le cinque chiavi per trasformare BigData in un grande business.

Velocità

Oltre alla gestione dei dati, le aziende hanno bisogno che tali informazioni fluiscano, il più vicino possibile al tempo reale.

Volume

Il volume è la base. Il volume di dati che le aziende gestiscono è salito alle stelle intorno al 2012, quando hanno iniziato a raccogliere più di tre milioni di pezzi di dati ogni dato.

Varietà

La terza V di BigData è varietà . Una società può ottenere dati da molte fonti diverse: dai dispositivi interni alla tecnologia GPS per smartphone o cosa dicono le persone sui social network. L’importanza di queste fonti di informazione varia a seconda della natura dell’azienda.

Veracità

La quarta V è la veridicità , che in questo contesto equivale alla qualità. Abbiamo tutti i dati, ma i dati sono “puliti” e precisi? Hanno davvero qualcosa da offrire?

Valore

Infine, la V per valore. Ciò si riferisce alla capacità di trasformare uno tsunami di dati in business.

Ma come facciamo effettivamente a gestire questa mole di dati?

Esiste un tool, il più comune, che ci viene incontro per dare una soluzione a queste problematiche, si chiama Hadoop.

Hadoop, Che cos’è e perché è importante?

Hadoop è un software open-source per l’archiviazione di dati su cluster. Mette a disposizione la propria memoria virtuale per un enorme volume di dati di qualsiasi tipo, un potente processore e la capacità di gestire virtualmente una quantità illimitata di compiti e lavori simultanei.

Perché Hadoop?

- Capacità di archiviare e processare un enorme volume di dati di qualsiasi tipo, velocemente. Caratteristica fondamentale per gestire il costante aumento dei volumi e la varietà dei dati.

- Computazione potente. I modelli computazionali distribuiti di Hadoop processano i big data velocemente. Maggiori sono i computing nodes che utilizzi e maggiore sarà la potenza del processore.

- Tolleranza ai guasti. I dati e i processori sono protetti dai guasti hardware. Se un nodo si guasta, le attività vengono automaticamente indirizzate ad altri nodi. Ogni dato viene automaticamente salvato in più copie.

- Flessibilità. A differenza dei database tradizionali, non c’è bisogno di elaborare i dati prima di memorizzarli. Puoi memorizzare tutti i dati che vuoi e decidere in seguito come utilizzarli. Inclusi i dati non strutturati, come testi, immagini e video.

- Low cost. Il framework open-source è gratuito e utilizza commodity hardware per archiviare un grande volume di dati.

- Scalabilità. Puoi facilmente aumentare i dati gestiti dal tuo sistema solo aggiungendo delle note. L’amministrazione richiesta è davvero minima.

Come viene utilizzato Hadoop?

Memoria e archivio di dati low-cost

Il costo modesto dei commodity hardware rende Hadoop utile all’archiviazione e combinazione di dati provenienti da transazoni, social media, sensori, macchinari, scienza, click streams, ecc. Lo spazio di archiviazione low-cost ti permette di tenere informazioni che al momento non si considerano fondamentali, ma che potresti voler analizzare più avanti.

Approccio sandbox, scoperta e analisi

Dato che Hadoop è stato progettato per avere a che fare con volumi di dati di diversa natura e forma, esegue gli algoritmi analitici. Gli analytics di Hadoop per i big data possono aiutare la tua organizzazione ad operare in modo più efficace, svelare nuove opportunità e ottenere vantaggio competitivo. L’approccio sandbox fornisce opportunità d’innovazione richiedendo investimenti minimi.

Data lake

I data lake mantengono nel loro format originale i dati archiviati. L’obiettivo è offrire ai data scientists e agli analisti righe di dati non raffinati da scoprire e analizzare. Questo li aiuta a porsi domande nuove o difficili senza alcun vincolo. I data lake non sono un rimpiazzo dei data warehouse. Infatti, il tema della sicurezza e dell’amministrazione dei data lake è molto importante per gli IT. Per creare strutture di dati logiche, essi fanno affidamento sulle tecniche di data federation.

Completa i tuoi data warehouse

Si può notare come Hadoop stia incominciando ad affiancare gli ambienti di data warehouse, e come alcune serie di dati si stiano riversando dai data warehouse ad Hadoop o ancora, come i nuovi tipi di dati stiano andando direttamente ad Hadoop. L’obiettivo finale di ogni organizzazione è avere la giusta piattaforma per immagazzinare e processare i dati di diversi tipi, in modo tale da essere di supporto a diversi casi di utilizzo applicabili su vari livelli.

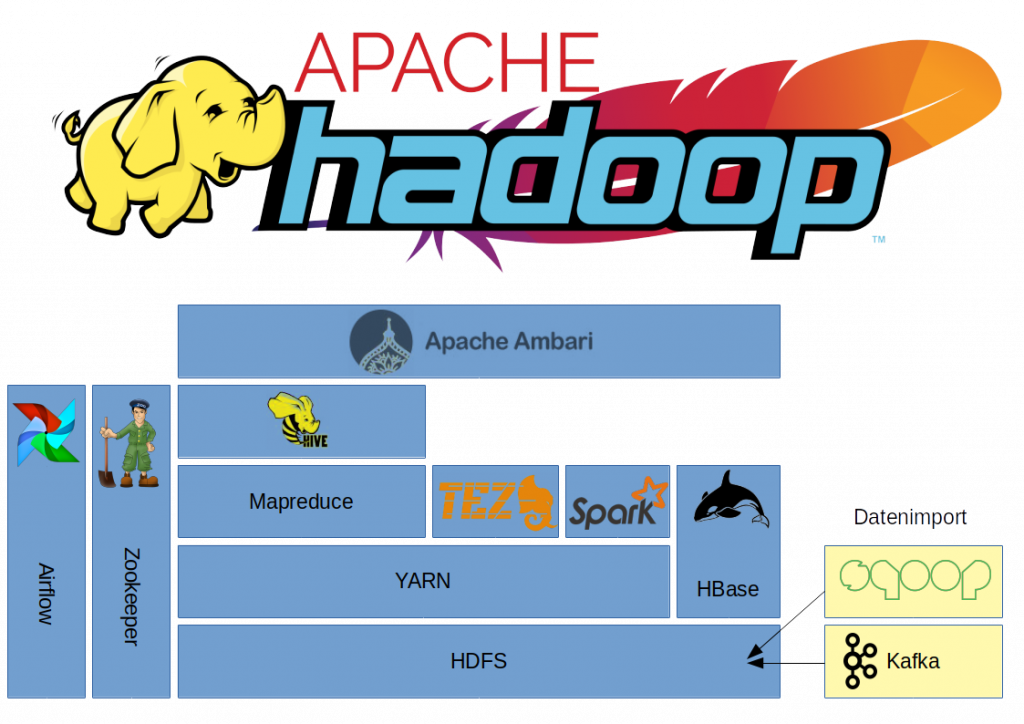

Componenti di Hadoop

- Hadoop Common – le librerie e i servizi utilizzati dagli altri moduli di Hadoop.

- Hadoop Distributed File System (HDFS) – il sistema scalare basato su Java che archivia dati attraverso più macchinari senza una precedente organizzazione.

- YARN – (Yet Another Resource Negotiator) aiuta la gestione delle risorse dei processi in esecuzione su Hadoop.

- MapReduce – un software framework di calcolo parallelo. È costituito da due fasi. La fase map è il nodo principale o master node in cui gli input vengono presi e ripartiti in sotto-problemi più piccoli e poi distribuiti ai nodi di elaborazione. Successivamente, il master node trasporta le risposte a tutti i sotto-problemi e le abbina tra loro per produrre degli output.

Alti elementi software che vengono eseguiti con (o affiancano) Hadoop, che hanno raggiunto lo status di progetto Apache di livello superiore, includono:

| Ambari | Un’interfaccia web per gestire, configuare e testare i servizi e gli elementi di Hadoop. |

| Cassandra | Un sistema di database distribuiti. |

| Flume | Software che collezionano, aggregano e muovono grandi volumi di dati streaming in HDFS. |

| HBase | Un database non relazionale distribuito che viene lanciato con Hadoop. Le tavole HBase possono servire da input e output per lavori di MapReduce. |

| HCatalog | Uno strumento di gestione del tavolo storage che aiuta gli utenti a condividere e accedere ai dati. |

| Hive | Un linguaggio d’interrogazione con infrastruttura datawarehouse simile a SQL che presenta i dati in forma di tavole. Programmare Hive è simile a programmare un database. |

| Oozie | Programmazione del lavoro di Hadoop. |

| Pig | Una piattaforma per manipolare i dati archiviati in HDFS che include un compilatore per i programmi MapReduce e utilizza un linguaggio complesso chiamato Pig Latin. Fornisce metodi per estrarre, trasformare e caricare i dati e alcuni basic analytics, in modo da non dover scrivere dei programmi di MapReduce. |

| Solr | Uno strumento di ricerca scalabile che include indexing, reliability, central configuration, failover e recovery. |

| Spark | Un framework di computazione con cluster open-source i cui analytics sono già in memoria. |

| Sqoop | Un meccanismo di connessione e trasferimento che sposta i dati tra Hadoop e i database relazionali. |

| Zookeeper | Un’applicazione che coordina il distributed processing. |

In conclusione, il mondo si evolve e con lui anche i dati, grazie a questi tool open source possiamo gestirli e controllarli. Un vero a proprio business che ha preso parte in quest’era dell’informazione, ogni nostro passo al giorno d’oggi genera dati, immagina a quanti dati arriveremo in là con gli anni.

Ogni tool in sé ha un mondo dietro, l’unico modo per saperne sempre di più è formarti, formarti e formarti costantemente. Il mondo si evolve velocemente, non farti lasciare indietro!